Amazon Web Services ブログ

DeepSeek-R1 が Amazon Bedrock のフルマネージドサーバーレスモデルとして利用可能に

1 月 30 日の時点で、DeepSeek-R1 モデルが Amazon Bedrock Marketplace と Amazon Bedrock のカスタムモデルインポートから Amazon Bedrock で使用可能になりました。それ以来、何千ものお客様がこのモデルを Amazon Bedrock にデプロイしてきました。お客様は、AI を安全にデプロイするための堅牢なガードレールと包括的なツールを高く評価しています。本日、新しいサーバーレスソリューションを始めとする拡張された豊富なオプションにより、DeepSeek in Amazon Bedrock がさらに使いやすくなりました。

Amazon Bedrock でのフルマネージド型の DeepSeek-R1 モデルの一般提供が開始されました。Amazon Web Services (AWS) は、DeepSeek-R1 をフルマネージド型の一般提供モデルとして提供した最初のクラウドサービスプロバイダー (CSP) です。AWS で DeepSeek を使用すれば、イノベーションを加速して具体的なビジネス価値を実現できます。複雑なインフラストラクチャを管理する必要はありません。Amazon Bedrock のフルマネージドサービスの単一の API を使用して、DeepSeek-R1 の機能で生成 AI アプリケーションを強化し、その豊富な機能とツールを活用できます。

DeepSeek によると、そのモデルは MIT ライセンスの下で一般公開されていて、推論、コーディング、自然言語理解の強力な機能を提供します。これらの機能は、インテリジェントな意思決定のサポート、ソフトウェア開発、数学的問題解決、科学的分析、データインサイト、包括的な知識管理システムを強化します。

すべての AI ソリューションと同様に、本番環境に実装する際はデータプライバシー要件を慎重に検討し、出力内のバイアスをチェックし、結果をモニタリングしてください。DeepSeek-R1 のような一般公開モデルを実装する際は、次の点を考慮してください。

- データセキュリティ – データの完全な制御を保持する一方で、責任を持って大規模に AI をデプロイするために不可欠な Amazon Bedrock のエンタープライズグレードのセキュリティ、モニタリング、コスト管理の機能にアクセスできます。ユーザーの入力とモデル出力は、いずれのモデルプロバイダーとも共有されません。保管中および転送中のデータの暗号化、きめ細かいアクセス制御、セキュアな接続オプション、さまざまなコンプライアンス証明書のダウンロードを始めとする主要なセキュリティ機能は、Amazon Bedrock の DeepSeek-R1 モデルとの通信中にデフォルトで使用できます。

- 責任ある AI – Amazon Bedrock ガードレールを使用すると、アプリケーションの要件や責任ある AI ポリシーに合わせてカスタマイズされたセーフガードを実装できます。これには、コンテンツフィルタリング、機密情報のフィルタリング、そしてコンテキストグラウンディングと自動推論チェックを使用してハルシネーションを防止するカスタマイズ可能なセキュリティ制御の主要な機能が含まれます。したがって、生成 AI アプリケーションで望ましくない有害なコンテンツをフィルタリングすることで、定義済みの一連のポリシーで Bedrock 内のユーザーと DeepSeek-R1 の間のインタラクションを制御できます。

- モデル評価 – Amazon Bedrock モデル評価ツールを使用して、自動評価または人間による評価により、数ステップでモデルを評価および比較して、ユースケースに最適な DeepSeek-R1 などのモデルを特定できます。精度、堅牢性、毒性などの事前定義されたメトリクスでの自動評価を選択できます。また、関連性、スタイル、ブランドボイスとの整合性などの主観的指標やカスタム指標について、人間による評価ワークフローを選択することも可能です。モデル評価では、組み込みの厳選されたデータセットを使用するか、独自のデータセットを使用することができます。

生成 AI アプリケーションの堅牢な保護を追加するために、Amazon Bedrock ガードレールを DeepSeek-R1 モデルと統合し、Amazon Bedrock モデル評価機能を使用することを強くお勧めします。詳細については、「Protect your DeepSeek model deployments with Amazon Bedrock Guardrails」と「Evaluate the performance of Amazon Bedrock resources」を参照してください。

Amazon Bedrock で DeepSeek-R1 モデルの使用を開始する

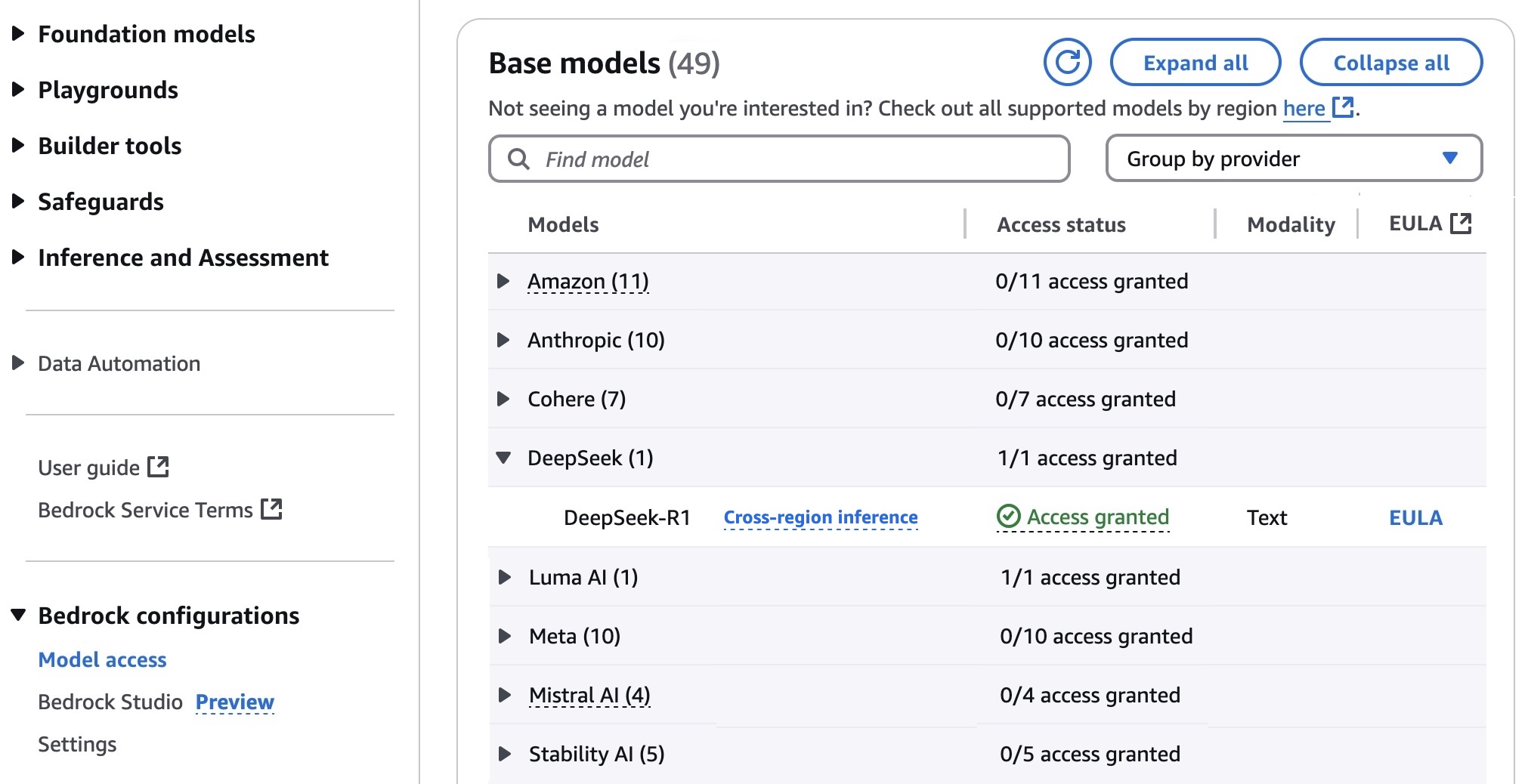

DeepSeek-R1 モデルを初めて使用する場合、Amazon Bedrock コンソールに移動し、左側のナビゲーションペインの [Bedrock configurations] で [モデルアクセス] を選択します。フルマネージド型の DeepSeek-R1 モデルにアクセスするために、[DeepSeek] の下にある [DeepSeek-R1] へのアクセスをリクエストします。Amazon Bedrock でモデルにアクセスできるようになります。

次に、Amazon Bedrock で DeepSeek-R1 モデルをテストするために左側のメニューペインの [プレイグラウンド] で [Chat/Text] を選択します。次に、左上の [モデルを選択] を選択し、[カテゴリ] で [DeepSeek] を選択し、[モデル] で [DeepSeek-R1] を選択します。次に、[適用] を選択します。

選択した [DeepSeek-R1] モデルを使用して、次のプロンプト例を実行します。

ある家族が来年の休暇に使用する 5,000 USD を貯金します。年間 2% の利息が付く普通預金口座、または年間 4% の利息で休暇まで預金を引き出すことができない定期預金口座に預金することができます。その年の急な出費として 1,000 USD を確保しておく場合、休暇用の資金を最大限に活用するためには、2 つのオプションの間で資金をどのように分配すべきでしょうか。

このプロンプトは複雑な思考の連鎖を必要とし、非常に正確な推論結果を生成します。

プロンプトの推奨される使用方法の詳細については、GitHub リポジトリにある DeepSeek-R1 モデルの README を参照してください。

[API リクエストを表示] を選択すると、AWS コマンドラインインターフェイス (AWS CLI) や AWS SDK でコードサンプルを使用してモデルにアクセスすることもできます。モデル ID として us.deepseek.r1-v1:0 を使用できます。

AWS CLI コマンドのサンプルを次に示します。

このモデルは、InvokeModel と Converse API の両方をサポートします。次の Python コード例は、テキスト生成用の Amazon Bedrock Converse API を使用して DeepSeek-R1 にテキストメッセージを送信する方法を示しています。

DeepSeek-R1 モデルで Amazon Bedrock ガードレールを有効にするには、左側のナビゲーションペインで [セーフガード] の [ガードレール] を選択し、必要な数のフィルターを設定してガードレールを作成します。例えば、「政治」という単語でフィルタリングすると、ガードレールはプロンプトでこの単語を認識し、ブロックされたメッセージを表示します。

さまざまな入力を使用してガードレールをテストし、ガードレールのパフォーマンスを評価できます。拒否トピック、ワードフィルター、機密情報フィルター、ブロックされたメッセージを設定してニーズを満たすことでガードレールを微調整できます。

Amazon Bedrock ガードレールの詳細については、AWS ドキュメントの「Stop harmful content in models using Amazon Bedrock Guardrails」を参照するか、AWS 機械学習ブログチャネルの Amazon Bedrock ガードレールに関するその他の詳細なブログ投稿を参照してください。

Amazon Bedrock でフルマネージド型 DeepSeek-R1 モデルを活用する方法を示すデモウォークスルーを以下に紹介しておきます。

今すぐご利用いただけます

DeepSeek-R1 は、米国東部 (バージニア北部)、米国東部 (オハイオ)、米国西部 (オレゴン) の各 AWS リージョンの Amazon Bedrock で、クロスリージョン推論を介してフルマネージドで利用できます。今後の更新については、全リージョンのリストを確認してください。詳細については、DeepSeek in Amazon Bedrock の製品ページと Amazon Bedrock の料金ページを参照してください。

Amazon Bedrock コンソールで DeepSeek-R1 を今すぐお試しいただき、AWS re:Post for Amazon Bedrock または AWS サポートの通常の連絡先からフィードバックをお寄せください。

– Channy

原文はこちらです。