G-gen の杉村です。当記事では、Google Cloud Next '25 in Las Vegas の、1日目のキーノートに関する速報レポートをお届けします。

- Google Cloud Next '25 in Las Vegas

- スンダーによる発表

- AI 特化のインフラ

- ストレージ

- AI 推論向けのソフトウェアアップデート

- Gemini for Google Workspace

- マルチモーダルな AI モデル

- Vertex AI の外部連携

- マルチエージェントの開発

- Google Agentspace

- Customer Engagement Suite

- データエージェント

- Gemini Code Assist Agents

- Security Agents

- 次回の Google Cloud Next

- 関連記事

Google Cloud Next '25 in Las Vegas

イベント概要

Google Cloud の旗艦イベントである Google Cloud Next。2025年の Google Cloud Next は、2025年4月9日(水)から11日(金)までの3日間です。

例年、初日のキーノート(基調講演)では、Google が最も強調したい発表が行われます。本投稿では、Google Cloud Next '25 の第1日目のキーノート(基調講演)で行われた発表から、特に注目すべきものにフォーカスして紹介します。

G-gen Tech Blog では、現地でイベントに参加したメンバーや、日本から情報をウォッチするメンバーが、Google Cloud Next '25 に関連する記事を発信します。

キーノートの発表

Google Cloud Next の開幕を飾る初日のキーノート(基調講演)では、Google Cloud の AI や AI エージェントに関連する新機能の発表や、顧客事例が紹介されました。

会場で、DJ が流す音楽にあわせて大型スクリーンに映される動画(VJ)は、Google の最新の動画生成 AI モデルである Veo 2 によって生成されたものです。2023年、2024年の Next に引き続き、本年のイベントも、Google による生成 AI へのコミットを強調したものであることがわかります。

冒頭では、Google Cloud の CEO であるトーマス・クリアンの短い挨拶のあと、Google とその親会社の Alphabet の CEO であるスンダー・ピチャイが登壇しました。昨年の Google Cloud Next では、スンダーは動画によるリモート出演でしたが、今回はステージ上に登壇し、観覧者の前に直接姿を表したことが印象的でした。

Google が強調したかったこと

今回の基調講演では、Google Cloud が「マルチエージェントのためのフルスタックプラットフォーム」であると強調されました。従来、Google Cloud は特にデータ分析の領域や Google Workspace を始めとするアプリケーションレイヤのサービス提供において、競合と比べた強みがあると考えられていました。しかし、初日のキーノートでスンダー・ピチャイが最初に発表したのは、Cloud WAN という、Google のバックボーンネットワークを企業がクラウド形式で利用可能にするサービスでした。

パブリッククラウドベンダーにとって企業の IT インフラを押さえることは、強力な顧客リテンションのメリットが得られ、重要です。また、新世代の TPU である Ironwood や NVIDIA との強固なパートナーシップが強調されました。基調講演では「AI ワークロードをインフラからアプリまでフルスタックでサポートできるプラットフォームが Google Cloud である」という点が繰り返し述べられました。また先日の Wiz 買収でも見られるように、セキュリティへの強いコミットもアピールされました。

このように、インフラサービス提供とセキュリティが万全であることをアピールし、AI を端緒にして企業インフラを押さえるのが Google の狙いであるとも考えられます。

スンダーによる発表

Alphabet の CEO スンダー・ピチャイが発表した内容は、今回の Google Cloud Next でも、Google が特に強調したい内容であると考えられます。

Cloud Wide Area Network(Cloud WAN)

スンダーによって初めに発表されたのは、海底ケーブルを含む、Google のバックボーンネットワークを、Google Cloud ユーザー企業向けに利用可能にする Cloud Wide Area Network(Cloud WAN)です。Google は世界中にネットワークインフラを張り巡らせており、200以上の国と地域に PoP(Points of Presence)を持ちます。

これにより、ネットワークパフォーマンスは40%向上し、TCO(総所有コスト)は40%削減される、としました。

詳細は、以下の公式ブログで発表されています。

Cloud WAN は、既存サービスである Cloud Interconnect、Cross-Cloud Interconnect、Network Connectivity Center(NCC)、および新発表の Network Connectivity Center Gateway(NCC Gateway。プレビュー開始は第2四半期 = 2025年4月からの3ヶ月間)で構成されます。Cross-Cloud Interconnect により、Google Cloud と他のパブリッククラウド(AWS、Azure、OCI 等)を接続し、Cloud Interconnect により Google Cloud とオンプレミス拠点を接続します。

こうして Google Cloud に接続されたすべてのサイトは、Google Cloud のバックボーンネットワークにより L2 層で相互に接続されるほか、Network Connectivity Center により、L3 層でのルーティングを制御できます。また新発表の NCC Gateway により、Security Service Edge(SSE)が提供され、Broadcom や Palo Alto Networks と統合したセキュリティ層が提供されます。これは、ファイアウォール、ルーティング、DNS 等の横断的な設定を可能にするソリューションであるとみられます。

今回、Cloud WAN を構成する1機能であり、Google Cloud に専用線で接続されたオンプレミス拠点同士が L2 レイヤで相互通信可能になる Cross-Site Interconnect がプレビュー公開されました。アジア地域では、日本がいち早く対応リージョンとなっています。

Ironwood(7th gen TPU)

続けてスンダーは、第7世代 TPU である Ironwood を発表しました。TPU(Tensor Processing Unit)とは、Google が開発した、機械学習向けの集積回路です。第6世代の TPU は2024年5月に Google I/O で発表されており、今回発表されたのはその後継モデルとなります。

「ポッドあたり9,000個以上のチップを搭載」「ポッドあたり42.5 exaflops の演算性能」「従来型の29倍の電力効率」により、前世代より10倍のパフォーマンスを発揮し、Gemini 2.5 のような思考モデルに対する拡大する需要に対応できるとしています。

Gemini 2.5 Flash

Gemini 2.5 Flash がまもなく(Coming Soon)利用可能になることも発表されました。

Google Cloud Next に先んじて、2025年3月25日には、思考型モデルである Gemini 2.5 Pro の試験運用版が利用可能になっていました。Gemini 2.5 Flash は、Pro よりも軽量で応答速度に優れたモデルです。利用料金単価も Pro より安価になり、より生成 AI アプリから利用しやすいモデルになります。

Gemini 2.5 Flash では、Thinking Budget(思考予算)が自動的に調整されるほか、明示的に指定することもできます。これにより柔軟に速度、精度、コストのバランスを調整できます。

Gemini 2.5 Flash は、これまでの Gemini 系モデルと同様に、Google Ai Studio、Vertex AI(Google Cloud)、Gemini アプリという3つのプラットフォームで使用可能になる見込みです。

なお、試験運用版(Experimental)で利用できた Gemini 2.5 Pro の Public Preview 版も発表されました。QPM(Query per minute)が20に緩和され、有償となっています。

Gemini に関する技術的な新発表については、以下の記事も参考にしてください。

AI 特化のインフラ

A4/A4X VM、NVIDIA Vera Rubin GPUs

A4 および A4X マシンタイプの Compute Engine VM が発表されました。A4/A4X マシンタイプは、それぞれ NVDIA の Blackwell アーキテクチャ GPU である B200、GB200 GPU を搭載したマシンタイプです。

A4/A4X は、大規模な機械学習ワークロードに特化したマシンタイプと考えられます。

A4 マシンタイプは2025年3月17日に発表済みですが、A4X マシンタイプは今回が初めての発表となりました。

また、NVIDIA の新世代 GPU である NVIDIA Vera Rubin GPUs が、クラウドプロバイダとして初めて、Google Cloud で提供されることが明らかになりました。

Cluster Director

Cluster Director は、大量のアクセラレーターをデプロイし、単一のまとまりとして管理するための機能です。発表時点で、一般公開(Generally Available、以下 GA)とされました。

以下の公式記事では、Cluster Director for GKE と Cluster Director for Slurm が発表されています。物理インフラ上への VM の展開やスケーリング、モニタリングを統合する機能が紹介されています。

ストレージ

AI ワークロード向けのストレージ

AI ワークロードのためのストレージ機能も、複数発表されています。前掲の A4/A4X VM や Cluster Director 等とあわせて、AI Hypercomputer スイートを構成しています。

- 参考 : Introducing Ironwood TPUs and new innovations in AI Hypercomputer

- 参考 : AI Hypercomputer overview

Hyperdisk Exapools

Hyperdisk Exapools は、エクサバイト級の容量と優れた IOPS を発揮するブロックストレージです。従来から存在する、Compute Engine 向けのブロックストレージである Hyperdisk の高性能版と見られます(Preview)。

Anywhere Cache

Anywhere Cache は、2025年3月13日に発表済みの機能です。Google Cloud のゾーンに Cloud Storage 用のキャッシュを作成し、Compute Engine VM とのレイテンシを短縮し、データ転送コストを節減できます(GA)。

Rapid Storage

Rapid Storage は、新発表の機能です。ゾーンレベルのオブジェクトストレージであり、ランダムアクセスにおいては従来比で5分の1のレイテンシを実現できるとされています(Preview)。

AI 推論向けのソフトウェアアップデート

GKE Inference Gateway

GKE Inference Gateway は、Google Kubernetes Engine(GKE)における 生成 AI 向け(Gen AI-aware)のスケーリングとロードバランシングの機能であり、コスト節減、レイテンシ低下、スループット向上に繋がるとされています(Preview)。

Pathways on Google Cloud

Pathways on Google Cloud は、Google DeepMind が開発した分散型機械学習ランタイムです(Preview)。Google 社内の大規模なトレーニングおよび推論のインフラを支えている技術です。

マルチホストによる推論(multi-host inferencing)を、動的スケーリングにより、最適なコストで実現するための機能とされています。数百のアクセラレーターを最適な組み合わせで稼働させるための管理ができると見られます。

Pathways on Google Cloud については、既に以下の Google Cloud ドキュメントが公開されています。

vLLM on TPU

vLLM が TPU で利用可能になります(GA)。

vLLM(virtual LLM、仮想大規模言語モデル)とは、LLM の推論を高速化することを目的とした、オープンソースライブラリです。既に vLLM を GPU で稼働させている場合、そのワークロードを TPU に移行することができます。

Gemini on Google Distributed Cloud

Gemini が Google Distributed Cloud で利用可能になります(Coming Soon)。

Google Distributed Cloud とは、Google のハードウェアを顧客のデータセンターに配置し、オンプレミスで Google Cloud ワークロードを稼働させられるサービスです。類似サービスとして、Amazon Web Services(AWS)の AWS Outposts 等が挙げられます。

また同時に、企業データの横断検索およびエージェントのサービスである Google Agentspace も、Google Distributed Cloud 上でホストできることが発表されました。

Gemini や Google Agentspace で高度にセンシティブなデータを扱う場合や、低レイテンシが重要視されるワークロードの場合、Google Distributed Cloud 上で Gemini を稼働させることが選択肢になります。

Gemini for Google Workspace

2025年、Gemini for Google Workspace がすべてのエディションで利用可能になりました。Google Workspace で利用可能な Gemini の新機能も多数、発表されました。

Help me analyze

Help me analyze 機能では、Gemini が Google スプレッドシートのデータを分析してくれます(Coming Soon)。明示的にプロンプトで指示しなくても、Gemini がシートからインサイトを見つけ出します。

Audio overviews on Docs

Audio overviews on Docs では、Google ドキュメントの文書から、高品質な音声による概要を生成します(Coming Soon)。

Google Workspace Flows

Google Workspace Flows は、AI エージェントが、さまざまな繰り返しタスクを自動化する機能です(Preview)。承認作業や市場調査、メールの整理、アジェンダの準備などが挙げられています。

マルチモーダルな AI モデル

Imagen 3

Imagen 3 は、画像生成モデルです。従来モデルから追加された機能として、Inpainting(修復)があります。画像の欠落部分を補完したり、逆に映り込んでしまった物体を消したりできます。

デモでは、ステージ上のギターの横に映り込んでしまった人間を「消しゴムマジック」のごとくマウスでなぞると、数秒の動画からきれいに人間が消える様子が実演されました。

Chirp 3

Chirp 3 は、会話音声の生成モデルです。既存の人物の音声を10秒程度インプットすると、それを基にしたカスタム音声を生成できるようになります。

Lyria

Lyria は、音楽を生成するためのモデルです。テキストのプロンプトから、30秒の音楽クリップを生成します。

Veo 2

Veo 2 は、動画生成モデルです。以前からプライベートプレビューが行われていましたが、この日の発表では、より包括的な動画制作、編集の機能が紹介されています。

デモでは、画像をインプットにしてカメラアングルやパンの方法の指定して動画を生成したり、動画の始まりと終わりの画像を指定するとその間を埋めるような動画を生成するなど、より高度な生成ができることがアピールされました。

Vertex AI での利用

Imagen 3、Chirp 3、Lyria、Veo 2 は、Vertex AI で利用できるようになります。これは個人向けの利用を超えて、企業向け(Enterprise-ready)に提供されることを意味しています。すなわち、セキュリティや品質、生成コンテンツの安全性が意識されたサービス提供がされることになります。

Vertex AI のプロダクトマネージャーである Nenshad Bardoliwalla によるデモでは、これまで存在しなかった Vertex AI Media Studio の UI が映し出されました。

Vertex AI の外部連携

Llama 4 on Vertex AI

Llama 4 が Vertex AI から利用できるようになります(GA)。

Vertex AI のサードパーティ連携

NetApp ストレージと Vertex AI が連携し、データを複製することなく、AI エージェント等から利用できるようになります。

他にも、Oracle、SAP、ServiceNow、Workday との連携などが強調されました。

Google Maps によるグラウンディング

Vertex AI で、Google Maps によるグラウンディングが可能になることも発表されました。生成 AI エージェント等が Google Maps から提供される地理的情報等をもとに、根拠付けを行うことができるようになります。

利用可能時期や、どのモデルから利用できるか等については、明らかになっていません。

マルチエージェントの開発

Agent Development Kit(ADK)

マルチエージェントシステムを開発するためのオープンソースフレームワークである Agent Development Kit(ADK)が発表されました。

ADK は、複数のステップのタスクをこなすエージェントを開発するためのフレームワークです。ADK を使用することで、「100行未満の直感的なコードで AI エージェントを構築」できるとされています。また、ADK は MCP(Model Context Protocol)をサポートしています。Google から発表されるソリューションで、MCP への対応を謳ったのは初めてとみられます。これにより、Gemini 等のモデルから一般的に公開される MCP サーバーを利用することができると考えられます。

また ADK では、決定論的(deterministic)なガードレイル制御が可能であるとしています。Google は AI エージェントについて、しばしば決定論的(deterministic)と生成的(Generative)を対義語として用います。生成 AI は再現性のないレスポンスを返すおそれがありますが、ADK の制御によって、ある程度制御可能な振る舞いをさせられることが期待されます。

ADK は、当初は Python 向けにのみ提供されますが、他の言語にも対応予定です。

また、講演内では触れられなかったものの、同日 Google は Agent Engine も発表しています。Agent Engine は、AI エージェントをデプロイするためのフルマネージドなランタイムです。エージェントのインフラ(スケーリング、セキュリティ、モニタリング)に加えて、セッション管理や評価を扱うことができます。Agent Engine は ADK と統合されており、モデルに依存しないため、Gemini のほか Claude、Mistral 等もホストすることができます。Google Agentspace との統合もサポートされる予定です。

Agent2Agent Protocol(A2A)

Agent2Agent Protocol(A2A)がオープンなプロトコルとして発表されました。Agent2Agent Protocol は AI エージェント同士が通信するためのプロトコルです。

Agent2Agent Protocol は、クライアントエージェント(子のエージェントを監督するエージェント)とリモートエージェント(実際にタスクを行う子エージェント)間の通信方法を定めるものです。マルチエージェントを前提としており、クライアントエージェントがリモートエージェントを見つけ出すために、リモートエージェントが自らの機能を広告(advertise)するためのエージェントカードや、実行するべき仕事であるタスク、その成果物であるアーティファクト、アーティファクトのフォーマットに関するネゴシエーション、OpenAPI 互換の認証・認可スキームなどを定義しています。

生成 AI エージェントにおけるプロトコルでは MCP(Model Context Protocol)が真っ先に浮かびますが、Agent2Agent Protocol はこれと競合するものではなく、「補完する(complements)」としています。

アクセンチュア、Box、デロイト、Salesforce、SAP、ServiceNow など、50社以上のパートナーがこのプロトコルの定義にコントリビュートしています。

Google Agentspace

Google Agentspace のデモ

Google Agentspace は、企業データの横断検索や、AI エージェントによるタスクの自動化が可能なサービスです。以下を参照してください。

この日の発表では、まだ Early Access 期間中である Google Agentspace の新機能が次々と発表されました。

Google Agentspace では、人間の代わりにタスクを実行するエージェントを利用できます。

Agent Designer(カスタムエージェントをノーコードで開発)、アイデア生成エージェント、Deep Research エージェントなど、Google Agentspace から利用可能なさまざまなエージェントが紹介されました。

Google Agentspace では、チャット形式で質問を投入すると、単なる横断検索や要約ではなく、自然言語による質問に答える形での顧客分析、要約した音声の生成など、さまざまなタスクを実行できることがデモされました。

AI を利用したフォーキャストと組み合わせてレポートを生成し、その結果をみて必要なメールを作成し、送信するなど、一通りの作業を Google Agentspace が代わりに実行し、業務時間を節約できることが示唆されました。

Agentspace integrated into Chrome

Google Agentspace が Chrome Enterprise と統合することが発表されました(Preview)。

Chrome ブラウザの検索ボックスから会社のデータを横断検索できるようになる機能とみられます。これにより、組織のデータの検索が容易になり、生産性が向上するとしています。

Customer Engagement Suite

顧客とのエンゲージメントを高めるための機能として、以下のような機能も発表されました。

- Human-like voices(人間のような音声)

- Streaming video support(動画のストリーミング入力が可能に)

- AI assistance to build agents(エージェント構築を AI が支援)

いずれも Coming Soon とされており、Conversational Agents(旧 Dialogflow CX)で実装されるとみられます。

- 参考 : Transforming customer experiences with AI agents and the next generation Customer Engagement Suite

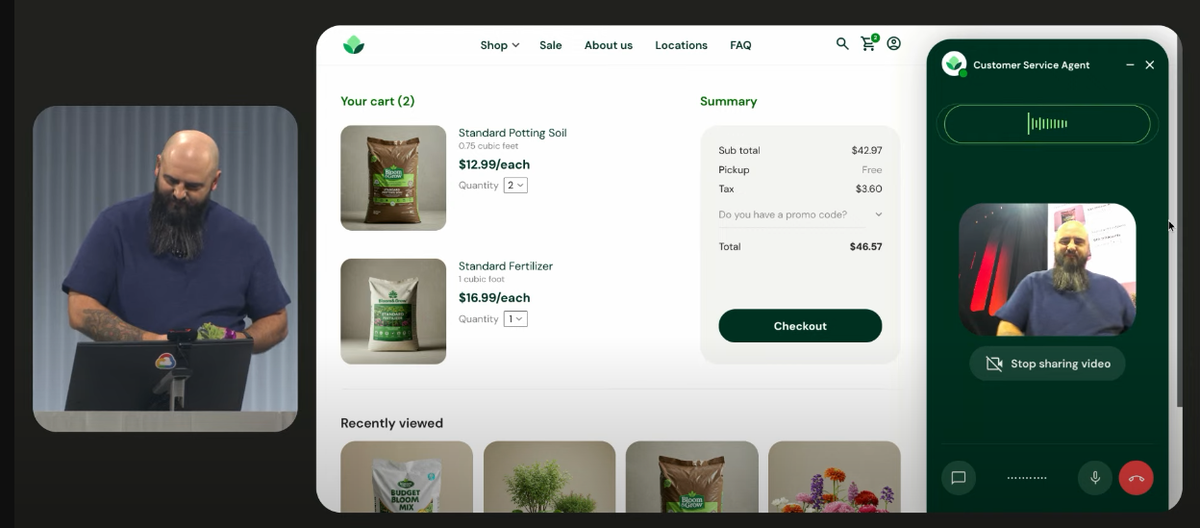

デモでは、カスタマーサービスエージェントが人間の問い合わせに音声で応答する様子が紹介されました。園芸用品の EC サイトを想定した、以下のようなデモが実演されました。

- 顧客がカメラに花を映すと、AI エージェントはその花がペチュニアであることを言い当てて、それにあった土や肥料をレコメンド

- 顧客がそれを気に入ったことを確認したら、レコメンドした製品を既にカートにあった商品と入れ替え

- 顧客が AI に無茶な値引きを要求すると、AI から人間にエスカレーション

データエージェント

データエージェントの実装

BigQuery を中心としたデータ活用は、Google Cloud において引き続き重要です。以前より Google Cloud は、データの活用を AI が支援するデータエージェント(Data Agents)の概念を提唱していました。この日は、これを推し進めるように、データエンジニアリング(Data Engineering)、データサイエンス(Data Science)、データアナリシス(Data Analysis)の各分野で、エージェント機能が強化されていることが紹介されました。

デモでは、BigQuery Studio 上で、AI 補助によるデータエンジニアリング機能である BigQuery data preparation などを用いて、自然言語による指示でデータを分析する様子が紹介されました。これまで以上に、データパイプラインの構築、ノートブック上での分析、可視化などが、生成 AI に対する自然言語の指示で容易に実現できるようになります。

BigQuery に関する新発表

基調講演では深く触れられませんでしたが、Next '25 では、BigQuery に関する発表も多数されています。特に、メタデータの自動生成や分析補助など、AI の補助のもとにデータ分析基盤の運用を効率化される機能が発表されたことは注目に値します。

BigQuery に関する技術的な発表は、以下の記事も参照してください。

Gemini Code Assist Agents

生成 AI がコーディングを支援する Gemini Code Assist では、Gemini Code Assist Agents が発表されました。これまで以上に、開発のライフサイクル全体がエージェントにより効率化されます。

カンバンボード(Kanban board)では、いわゆるカンバン方式で、開発者がエージェントと対話できます。

また、Atlassian、Sentry、Snyk 等、サードパーティと Gemini Code Assist の連携も紹介されました。

Gemini の支援によって実現する、開発の新しいスタイルについては、2日目の Developer Keynote(開発者向け基調講演)で詳しく紹介されました。

Security Agents

トリアージ、マルウェア検査

セキュリティエージェントの具体的な機能として、Google Threat Intelligence における Malware Analysys と、Google Security Operations(Google SecOps)における Alert Triage が挙げられました。いずれも Coming Soon とされています。

Google Unified Security(GUS)

Google が持つセキュリティソリューションを統合したソリューションとして、Google Unified Security(GUS)が発表されました。

Google Unified Security は、既存ソリューションである Google Security Operations(Google SecOps)、Google Chrome Enterprise(旧 BeyondCorp)、Mandiant(セキュリティに関するコンサルティング)、Security Command Center、Google Threat Intelligence を統合したソリューションです。

例として、Chrome Enterprise により、ブラウザのテレメトリが Google SecOps に送信され、脅威を検出して自動的に修復する、などの統合されたセキュリティ施策が実施可能とされます。

デモでは、Google Unified Security(GUS)のコンソール画面(UI)が紹介され、サードパーティの生成 AI モデルへの機密情報漏洩や、開発者がうっかり空けたファイアウォールからの攻撃への検知と対処が紹介されました。

AI Protection

Google Cloud の脆弱性を検知するサービスである Security Command Center にも、新機能が追加されます。

AI ライフサイクル全体のリスク管理を行うための AI Protection では、環境全体で AI がどのように利用されているかを検出し、カタログ化します。そのうえで Sensitive Data Protection(SDP)や Model Armor といったソリューションと連携し、情報漏洩や攻撃への対処を可能にします。

- 参考 : Announcing AI Protection: Security for the AI era

- 参考 : Security Command Centerを徹底解説。Google Cloud(GCP)の脆弱性を自動検知 - G-gen Tech Blog

- 参考 : Model Armorを徹底解説! - G-gen Tech Blog

次回の Google Cloud Next

次回の Google Cloud Next は、同じくラスベガスで、2026年4月22日から24日までの3日間で開催されることが発表されました。

関連記事

Google Cloud Next '25 の関連記事は、以下の記事一覧をご参照ください。開催期間中は、記事が随時公開されます。

杉村 勇馬 (記事一覧)

執行役員 CTO / クラウドソリューション部 部長

元警察官という経歴を持つ現 IT エンジニア。クラウド管理・運用やネットワークに知見。AWS 12資格、Google Cloud認定資格11資格。X (旧 Twitter) では Google Cloud や AWS のアップデート情報をつぶやいています。

Follow @y_sugi_it