はじめに

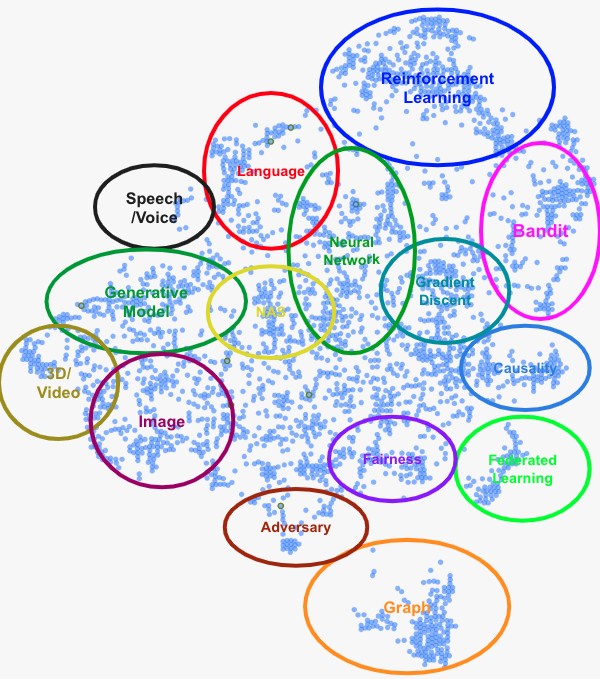

プロダクトオーナー兼機械学習エンジニアの本田志温です。 弊社高橋による前回の記事「NeurIPS 2022 参加報告 前編」 に引き続き、同会議の参加報告をします。本記事では、個人的に気になった論文(計53本)をいくつかのカテゴリで分類し、カテゴリごとに研究トレンドを大づかみにできるような形で書きます。特に重要だと感じた論文は詳しめに取り上げます。

また、本記事に関心をお持ちになった方は以下の過去記事もお楽しみいただけるのではないかと思います。ぜひ合わせてご覧ください。

深層学習の原理

深層学習は様々なタスクで高い性能を発揮することが経験的に知られていますが、「なぜうまくいくのか」という原理についてわかっていることは多くありません。そのため、既存の理論で説明できない現象について理論・実験の両面から様々な研究が行われています。

grokking

「不思議な現象」の一つに、grokking(日本語で言うと「腑に落ちる」くらいの意味)があります。grokkingとは、「過学習してしばらく経ってから、急に汎化誤差が下がり始める(正解率が上がり始める)」という現象のことで、2022年に初めて報告されました1。この正解率上昇の時間差は、訓練データが多いほど小さくなります。

この現象を説明する仮説として、「学習は初期化、過学習、表現学習の順で進む。grokkingとは過学習から表現学習への相転移である」というものが提案されています 2。検証データへの汎化性能は表現学習によって獲得されますが、データが少ないとそのプロセスが阻害され、相転移にかかる時間が拡大するというわけです。

スケーリング則の再考

スケーリング則もまた研究の余地が大きいテーマです。これは、「言語モデルなどのNNの性能が、訓練ステップ数、データセットのサイズ、パラメータ数の3変数の冪乗に比例する」という経験則です。この経験則が2020年に報告されて以来、「モデルの大規模化」が深層学習における一大トレンドになりました。本記事でもこの後で大規模モデルが度々登場します。

スケーリング則は高精度なモデルを作るための強力な指針となりますが、実際には冪関数の指数が小さいことがボトルネックになっており、「データを2倍に増やしても誤答率が2%しか改善しなかった」といったことがしばしばです。この原因が、データを増やすに従って情報利得の小さいサンプルの割合が増えることだとすれば、これらのデータを除去することで学習効率を改善できそうです。実際、「データが不十分なときは簡単な(決定境界から遠い)サンプルのみを、十分なときは難しい(決定境界から近い)サンプルのみを残す」という除去方法によって、学習効率を冪関数から指数関数に改善することができます3。下図はシミュレーションデータでの実験結果ですが、CIFAR-10などのデータを使った場合でも矛盾しない結果が得られています。

なお、スケーリング則を冪関数でフィットすることの妥当性には疑問符も付いており、より外挿性の高い関数を提案する研究も行われています4。

平坦解と最適化器

深層学習がうまく行く理由を平坦解(flat minima)という考え方で説明する仮説群があります。これは、パラメータ空間で損失関数がとる曲面を考えたときに、「解周辺が平坦な解の汎化誤差は小さい」というものです。NeurIPS 2022ではこの平坦解について、「層を重ねること5」や「正規化層の存在6」が解付近を平坦にしていると主張する研究がありました。また、平坦解の概念を取り入れた最適化器であるSWA(stochastic weight averaging)やSAM(sharpness-aware minization)の性能と挙動に関する比較調査もありました7。

既存の最適化器についても引き続き研究が進められています。ここでは2つを紹介します。1つ目は、Adamのハイパーパラメータであるβ1とβ2が収束・発散にどう影響するかを理論的に解析した研究8です。「β1とβ2を適切に選べばAdamは収束する」という重要な結果を勾配に関する制約なしで導出し、その結果が下図のようにMNISTやCIFAR-10での実験結果と合致することを確かめています。また、実用的なβ1とβ2の決定方法(β2をなるべく大きくとり、β1はβ1<√β2の範囲で選ぶ)も導出しています。

2つ目は、勾配降下法の最適なハイパーパラメータ(ステップサイズやモメンタムの係数など)を勾配降下法で求めるという研究9です。このアイディアが実際にうまく行くというだけでもおもしろいのですが、この操作はなんと再帰的に実行できます。つまり、「メタ勾配降下法」の最適なハイパーパラメータを「メタメタ勾配降下法」で決められるということです。再帰を繰り返すほど、ハイパーパラメータの初期値に対して頑健になるそうです。

深層学習の応用に向けて

ここからは、深層学習の中でも応用の場面を想定したトピックを見ていきます。

ニューラルネットワークへの攻撃

まずは、NNに対する攻撃の手法についてです。NNへの攻撃というと敵対的入力(adversarial example)が有名ですが、他にも様々な攻撃があり得ます。これらのリスクを把握し必要な対策をとっておくことは、実用において重要です。

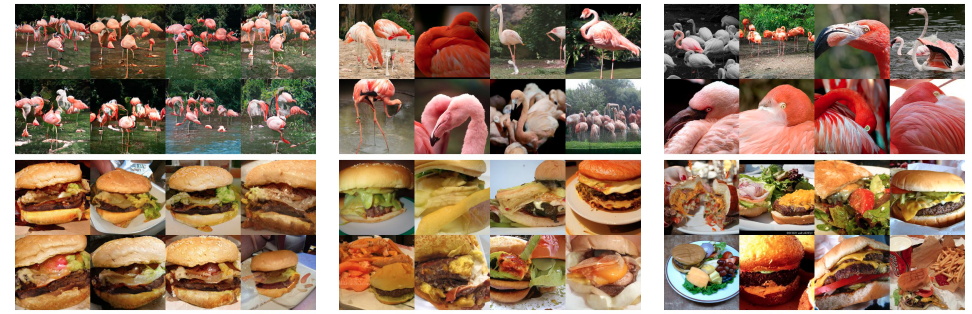

最初に取り上げるのは、「分類モデルから訓練サンプルを復元する」という攻撃手法です10。訓練サンプルの復元が生成モデルで可能なことは知られていました11が、分類モデルでも(パラメータが既知という仮定の下で)可能ということは本研究で初めて明らかになりました。

他にも、NNへの「バックドア攻撃」の新しい方法が提案されていました。NNへのバックドア攻撃とは、サプライチェーン上に仕掛けをすることで、特定の入力に対して意図した振る舞いをするようにさせるというものです。これまではデータや訓練コードを操作する方法が知られていましたが、NeurIPS 2022では新たに「NNのパラメータを手動で改ざんする」という手法が提案されていました12。

学習済みモデルの評価と編集

大規模モデルは一度作成したらいろいろなところで使い回すことが前提となっているので、多面的な評価をしておくことが肝要です。そのような動機から、NNが獲得した表現の「良さ」をタスクに依存しない形で評価する方法が研究されています13。また、画像を扱うモデルの望ましくない挙動を体系的に検査するフレームワークの提案14や、実際にImageNetにおける誤分類のパターンを調査した研究がありました15。

また、評価プロセスで見つかった「望ましくない挙動」を訓練後に修正する方法もいくつか提案されています。悪い挙動の原因となっている訓練サンプルを特定した上でその影響を取り消す手法16や、分布外(OOD; out of distribution)サンプルに対する確信度を調節する手法17などです。なお、訓練サンプルの削除はプライバシーの文脈でも行われています18。

大規模言語モデル

大規模モデルの原理や評価方法などについて述べてきましたが、大規模化の恩恵を最も受けているドメインは何かというと、テキストデータです。2018年のBERTの登場以降、言語モデルはモデルサイズを競う戦国時代に突入し、そうして生まれた大規模言語モデル(large language model; LLM)が複雑な自然言語のタスクやプログラミング問題などを解けるようになりました。NeurIPS 2022においても多数の研究が発表されていたので、その一部をここで紹介します。

コンテキスト内学習

GPT-3などのLLMは、推論時に与えるプロンプトからタスクを学ぶコンテキスト内学習(in-context learning)が可能です。「その結果、どれくらいの精度でタスクを解けるようになるか」はプロンプトの与え方(「タスク指示の上手さ」とも言えます)に依存するため、LLMの性能を最大化するようなプロンプトの与え方が研究されています。

LLMは小学校の算数の文章題のような問題を解くことができますが、2つ以上の思考ステップを踏むような問題は苦手です。例えば、「りんごが12個あります。2個を食べ、4個をアップルパイに使いました。残りは何個あるでしょう?」のような問題です。しかし、プロンプトにある工夫をすると、このような問題が解けるようになります。その工夫とは、「プロンプトに入れる具体例の回答部分に思考過程を含める」というものです 19。「回答だけではなく思考過程も一緒に教えると解けるようになる」という挙動はまるで人間のようで驚きですが、LLMはこのような汎化性能を有しているのです。

さらには、「回答を “Let’s think step by step.” という一文で始めるだけで、LLMが思考過程を含めた出力をするようになり、その結果として精度が上がる」という報告もありました 20。

少し視点が変わりますが、LLMのコンテキスト内学習の能力、すなわち「どのような関数クラスを学べるのか」という点で実験を行った研究もありました 21。

自然言語以外のタスク

LLMは数学やプログラミングなど、自然言語では表現しきれない問題においても一定の成果を出しています。PaLMというLLMを数学や物理の問題集でファインチューニングした「Minerva」はこれらの問題を既存手法を大幅に上回る精度で解くことができ 22ます。ソースコードのコーパスを用いた事前学習と強化学習によるファインチューニングを行った「CodeRL」は競技プログラミングの問題を解くことができます 23。

視覚言語モデル

最近では、視覚言語モデル(vision-language model; VLM)と呼ばれる、画像や動画データも扱えるLLMが登場しています。その代表例がFlamingo 24です。Flamingoは、LLMと画像エンコーダを注意機構で繋ぐことで、画像情報を踏まえたテキスト生成が可能です。下図の例で言うと、Flamingoは猫の画像を見ながら"This is"という文に続けて"a very serious cat.“という文を出力しています。Flamingoは、事前学習モデルを活用することで訓練パラメータを「繋ぎの部分」だけに絞っている点も注目に値します。LLMには後述するChinchilla 25というモデルを、画像エンコーダには事前学習済みのNFNet 26というモデルを採用しています。

他にも、(人間のように)一人称視点の映像だけで訓練したVLM 27や、言語は言語でも音声データを利用したVLM 28も発表されていました。

人間との協調

LLMは様々なタスクに適応する能力を有している一方、事前学習ではあくまで「次のトークンを予測するように」訓練されているので、生成される文章の品質や正確さは最適とは言えません。例えば、ループ再生のように同じ言葉を繰り返してしまったり、もっともらしい口調で嘘や自己矛盾を生成してしまったりといった挙動が知られています。そこで注目されているのがLLMの「協調性(alignment)」という概念です。ここで言う「協調性」には、ユーザの指示を汲み取って適切な返答をするだけではなく、「社会通念に反しないこと」のような暗黙的な要求も含まれています。

協調性研究で現在最も重要とされているのがInstructGPT 29です。InstructGPTはGPT-3をベースにしたモデルであり、次のようにして訓練されています。

- プロンプトと望ましい出力のペアを人手で作る

- 1を教師データとしてGPT-3をファインチューニングする(これを方策の初期値とする)

- プロンプトを2の方策に入れて複数の出力をサンプルし、人手で好ましい順に序列を与える

- 3を教師データとして報酬モデル(これもGPT-3だが、2とは別物)を訓練する

- 4の報酬モデルを使って2の方策を強化学習で訓練する(InstructGPT)

このように人間によるフィードバックに基づいてLLMを強化学習させる試みはRLHF(reinforcement learning from human feedback)と呼ばれ、新しい研究テーマとして大きな注目を集めています。 ChatGPT もその一例です。

計算コストの削減

LLMには、計算コストの高さゆえに実用上の制約が大きいという問題もあります。この問題を緩和するために、訓練時のコスト削減や訓練後のモデル軽量化など様々な対策が考案されています。

前出のChinchilla 25は、そのような取り組みから生まれた効率的なLLMです。この研究ではまず、与えられた(小さめの)FLOPsの中でTransformer型LMの最適なパラメータ数を探索するという予備実験を行いました。こうして得られたFLOPsと最適なパラメータ数の組を冪関数でフィッティングすると、GPT-3などの既存のLLMはFLOPsに対してパラメータ数が多すぎることがわかります。この「最適なパラメータ数」に従って設計したLLMがChinchillaです。Chinchillaは、同じFLOPsでより多いパラメータを持つモデル(Gopher)よりも下流タスクにおいて良いスコアを達成しました。この結果は単にLLMが軽量化できるということだけでなく、「最近のLLMは十分に訓練されていない」という重要な事実も明らかにしています。FLOPsを増やすためには、今よりも大規模なデータセットを作成する必要があります。

一方、FLOPsではなくメモリIOに着目して注意機構の計算を近似なしで効率化したのがFlashAttention 30です。注意計算のボトルネックはGPUのSRAMとHBM(high bandwidth memory)間のデータのやり取りにあるとし、これを削減するための計算方法を考案しました。この工夫により、注意機構の計算で2-4倍の高速化と10-20倍のメモリ削減が可能です。GPT-2の訓練全体で見ると2倍以上の高速化になります。これらの目覚ましい結果から、FlashAttentionはすでにPyTorchやtransformersなどの主要ライブラリに実装されているとのことです。

訓練後のモデル軽量化という観点では、LLMやTransformerに特化した量子化 31、蒸留 32、枝刈り 33の手法が提案されていました。

強化学習

強化学習については幅広いテーマの研究がありましたが、ここではTransformer及びLLMとの関係が深まっているオフライン強化学習を中心に取り上げます。

オフライン強化学習

この分野で最も注目されている研究の一つはDecision Transformerです。Decision Transformerは、オフライン強化学習の問題を言語モデリングのようにして解くTransformerで、NeurIPS 2021で発表されました 34。

今回のNeurIPSではこれを発展させる形で、未知のタスクへの適応性やスケーリング則のようなLLMが持つ性質をDecision Transformerでも確認した研究 35や、確率的な環境では性能が悪いという問題を掘り下げた研究 36が発表されていました。

また、オフライン強化学習とTransformerに関しては、テキストコーパスによる事前学習済みモデルが無関係な下流タスク(例:Atariのゲーム)に転移できるという興味深い現象が知られています 37。この現象について、ファインチューニングの過程や各層の重みを解析することで、事前学習によって「注意をどの範囲で向けるのか」というメタな知識が獲得されているとする仮説が報告されていました 38。

その他

オフライン強化学習以外の研究も多数発表されていました。以下に例を挙げます:

- 方策勾配法で使われる「ベースライン」の役割を再考 39

- 報酬が疎なタスク(例:迷路)への対策として採られるカリキュラム学習で、タスク間の転移に最適輸送を応用 40

- 貪欲方策の学習初期段階で価値関数が急激に変化する現象(policy churn)を発見、その原因を分析 41

コンピュータビジョン

コンピュータビジョンの研究は、画像・動画・3Dといった視覚データをうまく取り扱うための手法の研究と、データを生成するモデルに関する研究がありました。

画像の自己教師学習

画像単体を扱う研究の中では、自己教師学習が人気トピックの一つです(参考:「 画像に対する自己教師あり表現学習手法について 」)。

個人的に最もおもしろかったのは、テキストではなく画像を用いるvisual promptingというタスク指示の方法です 42。これは下図のように、入出力形式が画像であるモデルfに対して、入出力例で「セグメンテーション」「エッジ検出」などのタスクを指示するというものです。学習データがコンピュータビジョンの論文の図(9万枚)というのもユニークな点です(自己教師学習かというと微妙なところがありますが)。

もう少し自己教師学習の主流寄りの研究だと、対照学習の損失関数に「正(負)例である確率」を導入したエネルギーベース対照学習がありました 43。

画像以外の視覚データ

画像以外のデータ(例:動画、3D、シーン)を扱う研究も増えています。具体的には、画像中の存在する複数の物体の個別の表現を獲得できるSlot Attention 44というモジュールを、動画 45やシーン 46に拡張する研究が発表されていました。

生成モデル

生成モデルは単体で一分野を築いていますが、本記事ではコンピュータビジョンのドメイン、かつ拡散モデルに絞って紹介します。

2022年はDALL・E 2、Stable Diffusion、Imagenなど高性能な画像生成AIが目白押しでしたが、これらに共通するのは生成器に拡散モデルを採用しているという点です。2021年頃から拡散モデルがGANに取ってかわる動きがありましたが、その後の1年で一定の決着が付いたと言える状況になり、NeurIPS 2022では生成モデル関係の論文の大部分を占めていました。

上で例に挙げたImagen 47は、text-to-imageのテキストエンコーダ部分を大きくすることで、生成品質を保ちながら入力テキストにより忠実な画像の生成を可能にしました。

拡散モデルの最大の弱点は、生成に1000回程度の推論が必要なため時間がかかるという点です。この推論回数を減らすために様々な対策が考案されており、微分方程式を利用した手法 48や、拡散モデルを訓練・ネットワーク・サンプリングの3モジュールに分解して設計を再考した手法 49などがあります。これら2つの手法は既にStable Diffusionで採用されています。Stable Diffusionといえば、元論文 50を発表した研究室からは、テキスト入力から画像を生成する際に、外部データベースにある「テキストに合致する画像群」を元に画像生成するという新たな手法 51が発表されていました。

データセットとベンチマーク

機械学習によってできることが広がった結果として、新たなデータセットやベンチマークを作成する研究の重要性が増しています。NeurIPSでは2021年から「Datasets & Benchmarks(D&B)」という専用のトラックを開設してデータ中心のAI(Data-Centric AI)を後押ししています。ここでは、同トラックとメイントラックより、データセットやベンチマークに関連する研究を紹介します。

ここ数年のAIの進化は目覚ましいものですが、そのほとんどは静的なデータセットに基づく学習です。一方で、「身体性(embodiment)を持つエージェントが物理世界との相互作用から何らかの能力を獲得していく」という方向性の研究にはまだまだ伸びしろがあるように思えます。このようなエージェント、すなわちEmbodied AIを実現するためのステップとして、データセットやベンチマークを作成する取り組みが進められています。例えば、MineDojoは、3次元のサンドボックス型ゲーム『Minecraft』を元にしたEmbodied AIの訓練・評価のためのフレームワークです 52。プレイ動画やwikiに蓄積されたデータも提供されており、ユーザであるAI開発者は本家ゲーム同様のオープンエンドな使い方をすることができます。もう一つ例を挙げると、相互作用可能な家を再現した環境を自動で生成する、ProcTHORというフレームワークがあります 53。この論文では、手続き的に生成された大規模なデータセットがEmbodied AIの訓練に役立つことも検証されています。生成されたデータは 公式ページ で見ることができます。

3次元に関連して、バラバラに壊れてしまった物体を元通りに組み立てるという興味深いデータセットが提案されていました 54。出土品の復元などの応用先を想定しており、AIの活用領域の広がりが感じられます。

D&Bトラックでは、画像・キャプションペアの大規模データセットを初めて作成・公開したLAION-5B 55も注目を集めていました。近年、基盤モデル(foundation model)と呼ばれる汎化性能に長けたAIが一部の大企業を中心に開発されていますが、社内の独自データに依存するケースが増えており、研究の寡占化や再現性の危機の問題が叫ばれていました。LAION-5Bはこのような問題への対策として作成・公開されたデータセットです。

ベンチマークの作成も活発で、NNの最適化器 56、生成モデル 57、OOD検出 58などのテーマがありました。

音声とグラフ

最後に、ここまでの分類に収められなかった研究を簡単に紹介します。

音声認識では、Transformerのアーキテクチャを効率的にしたSqueezeformerという手法が提案されました 59。音声認識のTransformerといえば、OpenAIから発表された Whisper を連想する方も多いのではないかと思います。音声認識分野でも、Transformerが有力であることがわかります。

グラフの分野では、「グラフニューラルネットワークの事前学習は分子グラフ(molecular graph)の表現獲得に役立つか?」と題した研究 60が興味を惹きました。自然言語処理における事前学習を模倣する形で、分子グラフでも様々な自己教師の事前学習タスクが提案されています(例:あるノードの種類を周囲の情報から予測する)。前述の研究は、これらの事前学習の手法を精査したものです。その結果は、分子の性質を予測するという下流タスクへの貢献度合いは多くの場合において有意でないという意外なものでした。現状では事前学習の手法よりもデータセットの分割方法やハイパーパラメータ、そして特徴量の作り方が性能を支配しており、既存の事前学習タスクは下流タスクに比べて簡単過ぎるのではないかと考察されています。

おわりに

最後までお読みくださり、ありがとうございました。個人的な話をすると、大規模な国際会議に現地参加したのは今回が初めてでした。ポスター発表では最先端の研究成果を著者本人から説明してもらったり、スポンサーブースやレセプションでは業界の熱量を肌で感じられたりと、刺激的な体験ができました。自身の好奇心に任せて報告書をまとめていたらできあがったのが、この長編記事です。本記事が何かの参考になれば幸いです。

この後、長い脚注の次に弊社採用ページへのリンクがあるので、興味のある方は末尾までスクロールをお願いします。

-

Alethea Power et al. “ Grokking: Generalization Beyond Overfitting on Small Algorithmic Datasets ”. 2022. ↩︎

-

Ziming Liu et al. “ Towards Understanding Grokking: An Effective Theory of Representation Learning ”. In NeurIPS, 2022. ↩︎

-

Ben Sorscher et al. “ Beyond neural scaling laws: beating power law scaling via data pruning ”. In NeurIPS, 2022. ↩︎

-

Ibrahim Alabdulmohsin et al. “ Revisiting Neural Scaling Laws in Language and Vision ”. In NeurIPS, 2022. ↩︎

-

Jianhao Ma et al. “ Blessing of Depth in Linear Regression: Deeper Models Have Flatter Landscape Around the True Solution ”. In NeurIPS, 2022. ↩︎

-

Kaifeng Lyu et al. “ Understanding the Generalization Benefit of Normalization Layers: Sharpness Reduction ”. In NeurIPS, 2022. ↩︎

-

Jean Kaddour et al. “ When Do Flat Minima Optimizers Work? ”. In NeurIPS, 2022. ↩︎

-

Yushun Zhang et al. “ Adam Can Converge Without Any Modification On Update Rules ”. In NeurIPS, 2022. ↩︎

-

Kartik Chandra et al. “ Gradient Descent: The Ultimate Optimizer ”. In NeurIPS, 2022. ↩︎

-

Niv Haim et al. “ Reconstructing Training Data From Trained Neural Networks ”. In NeurIPS, 2022. ↩︎

-

Nicholas Carlini et al. “ Extracting Training Data from Large Language Models ”. In USENIX Security, 2021. ↩︎

-

Sanghyun Hong et al. “ Handcrafted Backdoors in Deep Neural Networks ”. In NeurIPS, 2022. ↩︎

-

Kumar Krishna Agrawal et al. “ α-ReQ : Assessing Representation Quality in Self-Supervised Learning by measuring eigenspectrum decay ”. In NeurIPS, 2022. ↩︎

-

Guillaume Leclerc et al. “ 3DB: A Framework for Debugging Computer Vision Models ”. In NeurIPS, 2022. ↩︎

-

Vijay Vasudevan et al. “ When does dough become a bagel? Analyzing the remaining mistakes on ImageNet ”. In NeurIPS, 2022. ↩︎

-

Ryutaro Tanno et al. “ Repairing Neural Networks by Leaving the Right Past Behind ”. In NeurIPS, 2022. ↩︎

-

Amrith Setlur et al. “ Adversarial Unlearning: Reducing Confidence Along Adversarial Directions ”. In NeurIPS, 2022. ↩︎

-

Vinith Menon Suriyakumar et al. “ Algorithms that Approximate Data Removal: New Results and Limitations ”. In NeurIPS, 2022. ↩︎

-

Jason Wei et al. “ Chain of Thought Prompting Elicits Reasoning in Large Language Models ”. In NeurIPS, 2022. ↩︎

-

Takeshi Kojima et al. “ Large Language Models are Zero-Shot Reasoners ”. In NeurIPS, 2022. ↩︎

-

Shivam Garg et al. “ What Can Transformers Learn In-Context? A Case Study of Simple Function Classes ”. In NeurIPS, 2022. ↩︎

-

Aitor Lewkowycz et al. “ Solving Quantitative Reasoning Problems with Language Models ”. In NeurIPS, 2022. ↩︎

-

Hung Le et al. “ CodeRL: Mastering Code Generation through Pretrained Models and Deep Reinforcement Learning ”. In NeurIPS, 2022. ↩︎

-

Jean-Baptiste Alayrac et al. “ Flamingo: a Visual Language Model for Few-Shot Learning ”. In NeurIPS, 2022. ↩︎

-

Jordan Hoffmann et al. “ An empirical analysis of compute-optimal large language model training ”. In NeurIPS, 2022. ↩︎

-

Andrew Brock et al. “ High-Performance Large-Scale Image Recognition Without Normalization ”. In ICML, 2021. ↩︎

-

Kevin Qinghong Lin et al. “ Egocentric Video-Language Pretraining ”. In NeurIPS, 2022. ↩︎

-

Zineng Tang et al. “ TVLT: Textless Vision-Language Transformer ”. In NeurIPS, 2022. ↩︎

-

Long Ouyang et al. “ Training language models to follow instructions with human feedback ”. In NeurIPS, 2022. ↩︎

-

Tri Dao et al. “ FlashAttention: Fast and Memory-Efficient Exact Attention with IO-Awareness ”. In NeurIPS, 2022. ↩︎

-

Tim Dettmers et al. “ GPT3.int8(): 8-bit Matrix Multiplication for Transformers at Scale ”. In NeurIPS, 2022. ↩︎

-

Dongkuan (DK) Xu et al. “ Few-shot Task-agnostic Neural Architecture Search for Distilling Large Language Models ”. In NeurIPS, 2022. ↩︎

-

Woosuk Kwon et al. “ A Fast Post-Training Pruning Framework for Transformers ”. In NeurIPS, 2022. ↩︎

-

Lili Chen et al. “ Decision Transformer: Reinforcement Learning via Sequence Modeling ”. In NeurIPS, 2021. ↩︎

-

Kuang-Huei Lee et al. “ Multi-Game Decision Transformers ”. In NeurIPS, 2022. ↩︎

-

Keiran Paster et al. “ You Can’t Count on Luck: Why Decision Transformers and RvS Fail in Stochastic Environments ”. In NeurIPS, 2022. ↩︎

-

Machel Reid et al. “ Can Wikipedia Help Offline Reinforcement Learning? ”. 2022. ↩︎

-

Shiro Takagi. “ On the Effect of Pre-training for Transformer in Different Modality on Offline Reinforcement Learning ”. In NeurIPS, 2022. ↩︎

-

Jincheng Mei et al. “ The Role of Baselines in Policy Gradient Optimization ”. In NeurIPS, 2022. ↩︎

-

Peide Huang et al. “ Curriculum Reinforcement Learning using Optimal Transport via Gradual Domain Adaptation ”. In NeurIPS, 2022. ↩︎

-

Tom Schaul et al. “ The Phenomenon of Policy Churn ”. In NeurIPS, 2022. ↩︎

-

Amir Bar et al. “ Visual Prompting via Image Inpainting ”. In NeurIPS, 2022. ↩︎

-

Beomsu Kim et al. “ Energy-Based Contrastive Learning of Visual Representations ”. In NeurIPS, 2022. ↩︎

-

Francesco Locatello et al. “ Object-Centric Learning with Slot Attention ”. In NeurIPS, 2020. ↩︎

-

Gamaleldin Fathy Elsayed et al. “ SAVi++: Towards End-to-End Object-Centric Learning from Real-World Videos ”. In NeurIPS, 2022. ↩︎

-

Mehdi S. M. Sajjadi et al. “ Object Scene Representation Transformer ”. In NeurIPS, 2022. ↩︎

-

Chitwan Saharia et al. “ Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding ”. In NeurIPS, 2022. ↩︎

-

Cheng Lu et al. “ DPM-Solver: A Fast ODE Solver for Diffusion Probabilistic Model Sampling in Around 10 Steps ”. In NeurIPS, 2022. ↩︎

-

Tero Karras et al. “ Elucidating the Design Space of Diffusion-Based Generative Models ”. In NeurIPS, 2022. ↩︎

-

Robin Rombach et al. “ High-Resolution Image Synthesis with Latent Diffusion Models ”. In CVPR, 2022. ↩︎

-

Andreas Blattmann et al. “ Semi-Parametric Neural Image Synthesis ”. In NeurIPS, 2022. ↩︎

-

Linxi Fan et al. “ MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge ”. In NeurIPS, 2022. ↩︎

-

Matt Deitke et al. “ 🏘️ ProcTHOR: Large-Scale Embodied AI Using Procedural Generation ”. In NeurIPS, 2022. ↩︎

-

Silvia Sellán et al. “ Breaking Bad: A Dataset for Geometric Fracture and Reassembly ”. In NeurIPS, 2022. ↩︎

-

Christoph Schuhmann et al. “ LAION-5B: An open large-scale dataset for training next generation image-text models ”. In NeurIPS, 2022. ↩︎

-

Thomas Moreau et al. “ Benchopt: Reproducible, efficient and collaborative optimization benchmarks ”. In NeurIPS, 2022. ↩︎

-

Clément Chadebec et al. “ Pythae: Unifying Generative Autoencoders in Python - A Benchmarking Use Case ”. In NeurIPS, 2022. ↩︎

-

Jingkang Yang et al. “ OpenOOD: Benchmarking Generalized Out-of-Distribution Detection ”. In NeurIPS, 2022. ↩︎

-

Sehoon Kim et al. “ Squeezeformer: An Efficient Transformer for Automatic Speech Recognition ”. In NeurIPS, 2022. ↩︎

-

Ruoxi Sun et al. “ Does GNN Pretraining Help Molecular Representation? ”. In NeurIPS, 2022. ↩︎

機械学習エンジニア

Shion Honda

好きな技術は深層学習、得意料理はポタージュです。