こんにちは。ZOZO Researchの研究員の古澤・北岸・平川です。2023年7月25日(火)から7月28日(金)にかけて画像の認識・理解シンポジウムMIRU2023に参加しました。この記事では、MIRU2023でのZOZO Researchのメンバーの取り組みやMIRU2023の様子について報告します。

目次

MIRU2023

MIRUとは、Meeting on Image Recognition and Understandingという画像の認識・理解についてのシンポジウムです。2023年の今回はアクトシティ浜松においてオフラインとオンラインのハイブリッド形式で開催されました。昨年に引き続き今年もハイブリッド開催ということで、過去最多の1513名(オンライン参加含む)もの方々が参加されたそうです。ZOZO NEXTは、このMIRU2023にゴールドスポンサーとして協賛させていただきました。

昨年のMIRU2022に参加した際のレポートは以下の記事をご覧ください。

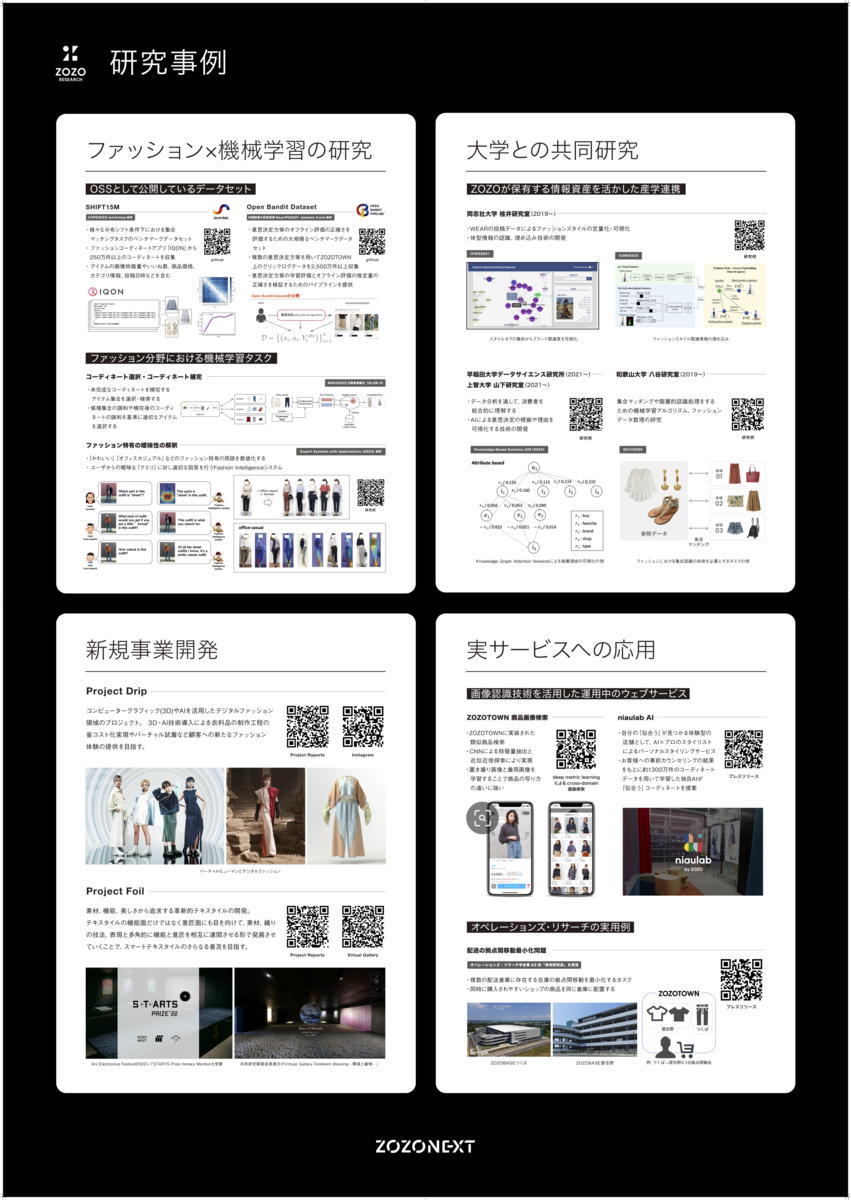

企業展示

企業展示ブースでは、ZOZO NEXTにおける取り組みについてポスターを用いて紹介させていただきました。ZOZOが提供する多角的なファッションサービスとそこから生み出される多様なデータを活用した研究事例について、最新の研究成果も交えて紹介させていただきました。大変喜ばしいことに多くの方々に興味を持っていただき、お話をさせていただくことができました。ブースまで足を運んでくださった皆さま、誠にありがとうございました。展示していたポスターはこちらです。

全体の動向

今回のMIRUでは、生成モデルと3Dモデルについての研究が目立ちました。特に生成モデルに関しては、昨年は敵対的生成ネットワークを使用する研究が多かったと記憶していましたが、今年はStable Diffusionなどで注目を集めている拡散モデルを用いた研究へとシフトが見られました。3Dモデルに関しては、昨年に引き続きNeural Radiance Fields (NeRF)に関する研究が行われており、新たにNeRFと拡散モデルを組み合わせる研究も見受けられました。

また、近年の生成モデルの発展を受け、「ニューラルデジタルヒューマン合成の最先端」と「大規模言語モデル時代のHuman-in-the-Loop機械学習」の2つのチュートリアル講演が行われました。前者の講演では、人間の3Dモデル生成について、敵対的生成ネットワークを用いた研究から近年の拡散モデルを使用した研究までレビューされており非常に興味深かったです。後者の講演では、クラウドソーシングによる大規模教師データの作成や安全性・公平性・多様性を担保するための人間からのフィードバックの活用について紹介がありました。

特別講義では、「画像と言語の基盤モデルの現状とこれから」と「見立てて見て取るための視覚的表現とインタラクティビティ」の2つの講演が行われました。前者の講演では、大規模モデルのサステナビリティや今後の発展の方向性などについても議論が行われ、今後の研究を考える上で大変参考になるお話を多く聞くことができました。また、後者の講演では、文脈などの見えないものを「見立てて見て取る」ヒトの能力を、コンピュータで解明するにあたっての課題と展望について伺いました。人が情報を認識するときに、情報そのものだけでなく、誰が言っているかなどの文脈を考慮して認識しているというご指摘が興味深かったです。

若手プログラム

弊社の研究員である後藤が、MIRU2023若手プログラムに参加しました。本プログラムは画像認識の分野で研究をしている若手を対象に、研究・開発を進める上で役立つ知見を学び合い、参加者同士で交流をする企画です。今年は「データをMIRU」をテーマに、9つのグループに分かれて画像認識に深く関わりのある様々な領域のサーベイを行いました。

後藤は、「データとプライバシー」に関するグループサーベイを行いました。データ駆動のビジネスモデルが勢いを強める中、学習データや出力に関するプライバシーや著作権に関する訴訟が増加しています。作成した資料では、公開データセットの学習に関するプライバシーの問題点を明らかにし、データセット・法律・アルゴリズムによる解決法を議論しています。

若手の会グループサーベイ資料は以下のページから見ることができます。

インタラクティブセッション

ZOZO Researchからはインタラクティブセッション2件を発表しました。各研究の要約は以下の通りです。

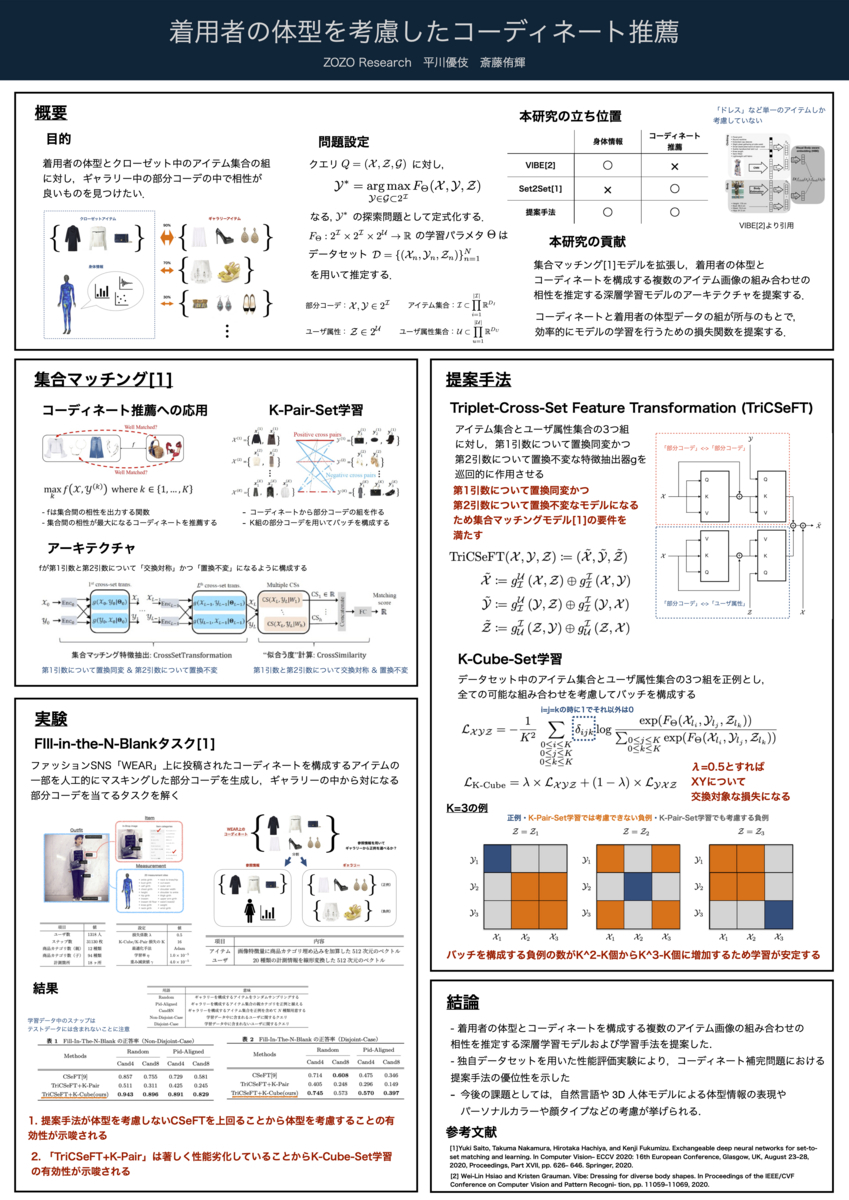

[IS3-46] 着用者の体型を考慮したファッションコーディネート推薦

平川優伎, 斎藤侑輝 (ZOZO Research)

パーソナライズされたファッションコーディネート推薦を実現する上で着用者の体型情報は重要な情報です。一方で、先行研究としてドレスなど単一のアイテムと体型情報を考慮した研究が知られていますが、複数のアイテムから成るコーディネートを考慮する場合は議論の余地があります。そこで、本研究では集合マッチングに基づくコーディネート推薦モデルを拡張し、着用者の体型とコーディネートを構成する複数のアイテムの相性を推定する深層学習モデル及び学習手法を提案しました。さらに、コーディネートを構成するアイテム画像と着用者の体型データから成る独自データセットを用いた性能評価実験により、コーディネート補完問題における提案手法の優位性を示しました。

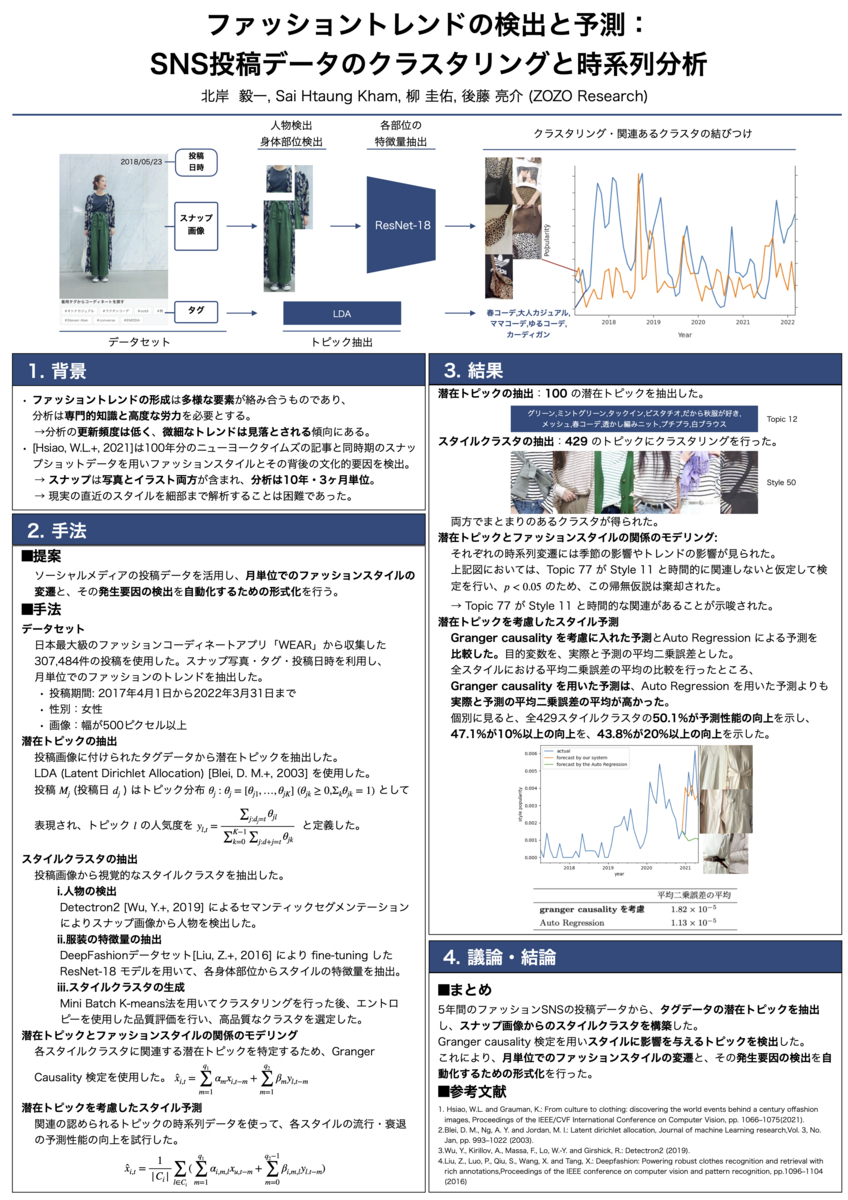

[IS3-87] ファッショントレンドの検出と予測:SNS投稿データのクラスタリングと時系列解析

北岸毅一, Sai Htaung Kham, 後藤亮介 (ZOZO Research)

ファッショントレンドの形成は多様な要素が絡み合うものであり、その分析は専門的知識と高度な労力を必要とします。これにより、トレンドの分析が頻繁に更新されることは少なく、微細なトレンドは見落とされる傾向にあります。本研究では、5年間のファッションSNSの投稿データから、タグデータの潜在トピックを抽出し、スナップ画像からのスタイルクラスタを構築しました。さらにGranger causality検定を用い、スタイルに影響を与えるトピックを検出しました。これにより、月単位でのファッションスタイルの変遷と、その発生要因の検出を自動化するための手法を確立しました。

気になった研究発表

私たちが個人的に興味を持った研究について紹介します。

[OS3B-L2] Instruct 3D-to-3D: Text Instruction Guided 3D-to-3D conversion

Hiromichi Kamata, Yuiko Sakuma, Akio Hayakawa, Masato Ishii, Takuya Narihira (Sony Group)

この研究では、テキストの指示に従って画像を編集する拡散モデルであるInstructPix2Pixの拡張として、テキスト指示による3Dモデルの編集に取り組んでいます。ただし、単純に学習方法を3次元に拡張するのではなく、NeRFとInstructPix2Pixを組み合わせることで3Dモデルの編集を実現しています。具体的には、まず、元の3Dモデルを作成するsourceモデルとそのコピーとしてtargetモデルを準備します。次に、元の3Dモデルから取得した2D画像に対しノイズを加え、InstructPix2Pixでテキストに基づきノイズを推論します。最後に、ノイズの推論結果からScore Distilation Samplingと呼ばれる方法でtargetモデルの勾配を取得し、targetモデルの重みを更新していきます。これにより編集後の3Dモデルを作成するモデルを得ることができるとのことです。また、この研究では、Dynamic Scalingという提案手法により編集強度の制御を可能にしているそうです。結果はこちらのプロジェクトページからも見ることができるそうなので、興味のある方はぜひ見てみてください。

[OS4A-L2] 数式ドリブン教師あり学習によるセマンティックセグメンテーション

篠田理沙 (AIST, 京大), 速水亮 (AIST, 東京電機大), 中嶋航大 (AIST), 井上中順, 横田理央 (東工大), 片岡裕雄 (AIST)

データセットの作成の際には、各データに正解ラベルを付与するのには膨大な人的・時間的コストが掛かってしまうという課題や不適切なデータが混入してしまう危険性があります。この研究では、特にセマンティックセグメンテーションというタスクに着目し、様々な中空の多角形を数式に基づいて生成することで、実画像や人手のアノテーションを必要としないデータセットを作成されていました。さらに、提案データセットとCOCO-Stuff-164kという実画像データセットのそれぞれについて事前学習を行なったモデルの、ファインチューン後の精度を比較されていました。結果としては、ADE-20k・Cityscapesという実画像データセットに対するファインチューンについて、提案データセットを用いたモデルの方がより良い結果を出したとのことです。個人的には、数式に基づいてデータを生成しそれを学習することで、実画像よりも良い事前学習ができてしまうというのはとても面白くかつ強力な手法であると思いました。企業で研究している身としては、商用利用が可能な点も非常に嬉しい点です。また、画像データだけではなく、音声や言語といったデータにも拡張できるのかといった点も気になりました。

[OS1A-L2] アテンションはアノテーションの代わりになるか?:テキスト−画像生成モデルの注意機構を利用した領域分割の弱教師あり学習

吉橋亮太, 大塚雄也, 土井賢治, 田中智大 (ヤフー)

近年、Semantic Segmentation、Poanoptic Segmentation、Instance Segmentationなど様々な領域分割タスクに関する研究が盛んに行われています。一般に、領域分割モデルの学習には大量のセグメンテーションマスク付きの画像が必要になりますが、1枚あたりのアノテーションコストが非常に高いため、データセットサイズがスケールしないという課題があります。本研究では拡散モデルベースの画像生成モジュールと領域分割モジュールを組み合わせることで、テキストと画像のペアからセグメンテーションマスク付き画像をEnd-to-Endに生成する手法を提案されています。このアプローチでは、セグメンテーションマスクのアノテーション付き画像が生成されるため、領域分割モデルの学習データとして使用する場合に、アノテーションが原理的に不要になります。PASCAL VOCデータセットを用いた実験では提案手法は生成データのみを用いてmIoU 50%程度と比較的良好な結果を達成できたそうです。ファッションの領域においても、スナップ画像の認識タスクなどを高精細に実行するためには、領域分割の技術が必要不可欠です。本研究のようなアプローチを用いて生成した大量のラベル付き画像を用いて半自動的に学習した領域分割モデルを、実データの分析や認識モデルの性能向上に活かすことができるのか気になります。

[IS2-16] セグメンテーションマスクを利用した動画からの静的なNeRF表現の学習

大隣嵩 (東大), 池畑諭 (NII, 東工大, 東大), 相澤清晴 (東大)

この研究は、動く物体を含む動画からのNeRF表現の学習に関する研究です。NeRFは、特定の物体を様々な角度から撮影し、その結果をもとに高品質な3Dモデルを生成する技術です。複数の角度から撮影された画像を動画で代用する研究はよく知られていますが、撮影中に物体が動いてしまうと3Dモデルの作成が難しくなるという課題が存在します。この問題を解決するため、SegFormerから取得したマスクをタスクに合わせて拡張し、動的な物体を除外して3Dモデルを生成するという提案がされていました。具体的には、Test-time augmentation(複数の拡張結果を融合させることでエラーを軽減する)や、Gradual mask dilation(動く物体を覆う領域を広げて動く物体をもれなく学習から除外する)という方法を用いたとのことです。ファッション分野においても、このような手法の進化により、より容易にリアルな質感の3Dモデルが作成できるようになる可能性があると感じました。

まとめ

本記事では、MIRU2023の参加レポートをお伝えしました。昨年に引き続き今年のMIRUも現地で楽しむことができ、研究のトレンドや技術進展を学び、多くの方々と意見交換を行う良い機会となりました。MIRU2023で得られた知見や経験を今後の研究に取り入れ、より良い研究開発を行なっていきたいと思います。

最後に

ZOZO NEXTでは次々に登場する新しい技術を使いこなし、プロダクトの品質を改善できるエンジニアを募集しています。ご興味のある方は、以下のリンクからぜひご応募ください。

おまけ

学会の合間にさわやかのハンバーグを食べに行きました。さわやかはTV・YouTube等で何度も取り上げられている有名なハンバーグ店で、新鮮な牛肉を使ったハンバーグを実際に味わうことができたのは非常に嬉しかったです。