【再増枠】ITエンジニアのためのDeepLearning #12 with AMD

イベント内容

ITエンジニアのためのDeep Learning

以前から好評いただいているこのDeepLearningイベントもついに12回目になりました。 今回はAMD様、Acube様にご協賛いただき開催します。

会場

- 場所: TKP東京駅前カンファレンスセンター 東京都中央区八重洲1丁目5-20石塚八重洲ビル (Google Map)

- アクセス

- JR東京駅八重洲北口から徒歩1分

- 東京メトロ銀座線 日本橋(東京都)駅 A3出口 徒歩3分

- 都営浅草線 日本橋(東京都)駅 A3出口 徒歩3分

- 東京メトロ丸ノ内線 大手町駅 B9出口 徒歩3分

- 東京メトロ千代田線 大手町駅 B9出口 徒歩3分

- 東京メトロ半蔵門線 大手町駅 B9出口 徒歩3分

- 都営三田線 大手町駅 B9出口 徒歩3分

12の内容(今回の内容)

- 日本人工知能学会 全国大会2018の概要紹介

- ROCm-TensorFlow RadeonGPUでのセットアップ方法

- リアルタイム StyleTransformデモ on RadeonGPU

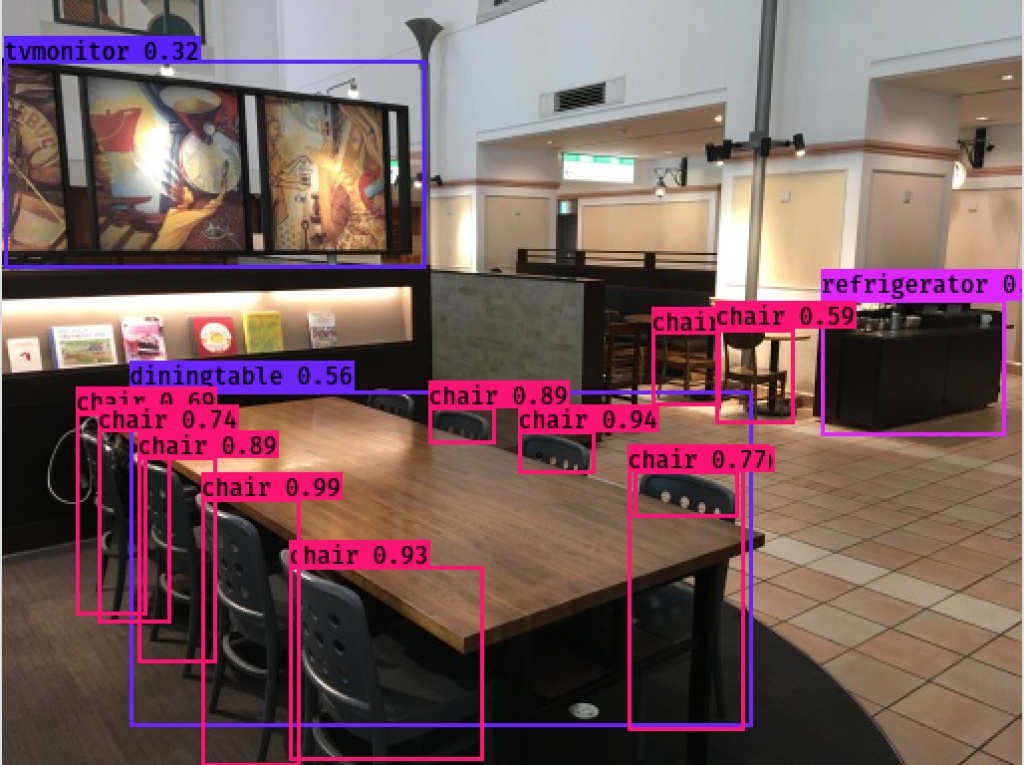

- リアルタイム YoloV3デモ on RadeonGPU

- NeuralStyleTransferとリアルタイム変換に使う仕組み

- GPUを取り巻く状況とGPUEater

- AMD GPUドライバROCmの現状を知る

- Radeon GPUでのDeepLearning対応ライブラリの状況 ◯✕表

- Radeon GPUでの最新のDeepLeanringモデルの表現評価と◯✕表

- AMDGPUとNVIDIAGPUとCPUの数百以上のテストケースと動作状況

- AMDGPUとNVIDIAGPUとCPUの最新のDeepLearningモデルのベンチマークとアノマリ

DeepLearning、機械学習には様々な落とし穴があります。 メディアやトレンドに惑わされずしっかりとしたリテラシーを持ち、適材適所に施行しなければその落とし穴にハマり、多くの時間とお金を無駄にします。このDeepLearningのイベントを通じて、参加者との意見交換を通じ正確なリテラシーを持つことを目的としていますので、ぜひぜひ懇親会で様々な方々とお話をしてみてください!

*一部の登壇者のスライドは撮影禁止となっていますので、ご協力をお願い致します。

タイムスケジュール

| 時間 | 内容 |

|---|---|

| 18:30〜19:00 | 開場 |

| 19:00〜19:05 | イントロダクション |

| 19:05〜20:00 | 登壇者発表 |

| 20:00〜21:45 | 懇親会 |

参加費

無料

今までのセッションの内容

#11の内容

- Darkflowの使い方とYoloV2/Yolo9000

- 転移学習について

- Radeon GPU+DeepLearningの現状

- 永続化コンテナとGPUの利便性

- NVIDIA EULA事件について

- GPU Eater クラウドと最新のGPUテクノロジー

- AMD-Radeon/NVIDIA GPUでの学習と推論ベンチマーク

- "TensorCore" 120TFlopsの正体を見極める

- TensorFlow on OpenCL

- Keras on PlaidML

- フレーム問題

- Findyのスキル偏差値算出アルゴリズムについて

- Findy Scoreの求人票解析アルゴリズムについて

- 身近な学習パラメータの決定例、「最小二乗法」の意味を考える

#9の内容

- DeepLearning Summit in San Francisco レポート

- 技術<データの重要性

- アンサンブル学習の重要性

- 認識に於ける2つの谷

#8-2の内容

Microsoftフィリピン本社にて英語登壇

- 料理認識デモ

- AI技術の限界の紹介

- アウトオブフレーム問題

- 予算、費用対効果について

#8の内容

- 1~7までのダイジェスト

- DCNNの派生系DCGAN(Deep Convolutional Generative Adversarial Network)

- 生成モデルの概要

- DCGAN実践

- 変換モデルの概要

- スタイル変換実践

#7の内容

- DeepLearningの精度と計算時間

- ニューラルネットは分散しにくい

- パラメータ探査の困難さ(モンテカルロ法、遺伝的アルゴリズム、Q学習)

- CPUとGPUの性質

- GPGPUとトレードオフ(台所事情)

- DeepLearningに於けるアクセラレートポイント

- 失敗したOpenCLと、囲い込みのCUDA

- 設備投資について

- 費用対効果と相場

- 持つものと持たざるもので分かれる機械学習

#6の内容

- ニューラルネットワーク基礎

- 偏微分連鎖律と数式を無視する型破りなバックプロパゲーションの理解

- 教師あり学習のデモ

- Weightsを視覚化してみる

- DCNN(DeepConvolutionalNeuralNetwork)を徹底解剖します!

- Convolution層とMaxPoolingの働きについて

- Convolution層とMaxPoolingのバックプロパゲーションの理解

- Convolution層の多層化の意味について

- Convolution層のWeightsを視覚化してみる

- DCNNの派生系についてのお話

#5の内容

- ニューラルネットワーク基礎

- 偏微分連鎖律と数式を無視する型破りなバックプロパゲーションの理解

- 教師あり学習のデモ

- Weightsを視覚化してみる

- 教師なし学習のデモ

- 主成分分析を視覚化してみる

- DeepLearningの深さの利点について

- 失敗から学ぶ。勾配消失問題を味わってみよう!

- チューニングの全体像

- プレトレーニングは時代遅れ

- 失敗から学ぶニューラルネットワーク

- MLPに於ける失敗するパラメータの事例

- StackedAutoEncodersに於ける失敗するパラメータ事例

- DCNNに於ける失敗するパラメータ事例

#4の内容

- 多クラス分類について

- 教師ありデータ収集について

- オントロジーとは?

- オントロジーの定義の難しさ

- ImageNetやコンペティションの公共のデータ

- WEBクローラーの作り方

- BOT対策について

- データ解析ツールの作り方とOpenCV

- 漫画やサムネイル、別サイズの同じ画像の除去

- ラベル貼り付けとコストについて

#3の内容

大枠の概要

- DeepLearningの歴史と重要なネットワーク

- 選択すべきネットワークの形とそのメリット&目的の理解

- ライブラリの選択とセットアップ

- DCNNじゃなくてフルコネクションネットワークと画像解析

技術詳細

- 教師あり学習の基礎(Perceptron/MLP)

- 教師なし学習について

- 教師なし学習の役割と活用例

- AutoEncoder/StackedAutoEncodersで次元圧縮と分析

- AdamとSGDとAutoEncoderの成功と失敗パラメータ

#2の内容

大枠の概要

- DeepLearningの歴史と重要なネットワーク

- 選択すべきネットワークの形とそのメリット&目的の理解

- ライブラリの選択とセットアップ

- DCNNのパラメータ設定

技術詳細

- DCNNの形の理解

- PerceptronとMLPとDCNNの関係

- ニューラルネットワークの基礎

- PerceptronとMLPの予測計算を絵で理解する

- PerceptronとMLPのバックプロパゲーション計算を絵で理解する

#1の内容

大枠の概要

- DeepLearning専門用語解説

- 選択すべきネットワークの形とそのメリット&目的の理解

- ライブラリの選択とセットアップ

- データ読み込み機構とアウトプット機構(画像編)

- データ収集とWEBクローラー(画像編)

- ラベル付の効率化(画像編)

- DCNNのパラメータ設定

技術詳細

- データの水増し編 (アフィン変換、ノイズ、ディストーション、プロジェクション、カラー)

- データランダマイズサンプル

- ランダムデータと正規分布データ

- データ正規化(ZCA/PCA Whitening)

- 活性化関数の選択

- MaxOut実装方法

- バッチ正規化と最新の活性化関数ELU(ReLuじゃないヨ)

- L1/L2正則化とAdaGrad/RMSProp/AdaDelta/Adam/AdaMax

- オントロジーとデータ整頓

- 平均予測

- GPGPUの台所事情

注意事項

※ 掲載タイミングや更新頻度によっては、情報提供元ページの内容と差異が発生しますので予めご了承ください。

※ 最新情報の確認や参加申込手続き、イベントに関するお問い合わせ等は情報提供元ページにてお願いします。

新規会員登録

このイベントに申し込むには会員登録が必要です。

アカウント登録済みの方はログインしてください。

※ ソーシャルアカウントで登録するとログインが簡単に行えます。

※ 連携したソーシャルアカウントは、会員登録完了後にいつでも変更できます。